Dr. Marco V. Benavides Sánchez.

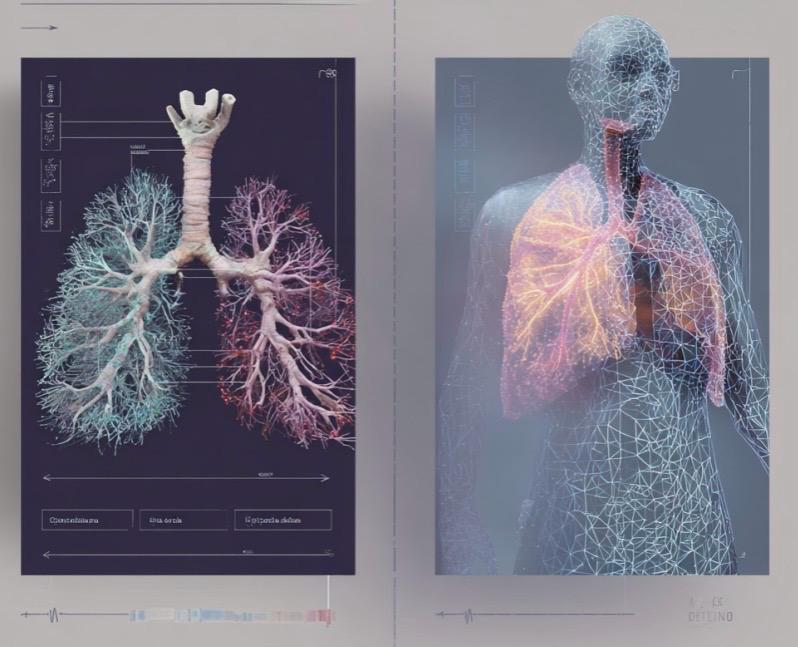

Nel mondo della medicina moderna, la segmentazione delle immagini ha un ruolo cruciale. Si tratta del processo mediante il quale vengono identificate e separate strutture anatomiche specifiche — come tumori, organi o vasi sanguigni — all’interno di immagini diagnostiche, come TAC, risonanze magnetiche e radiografie. Tuttavia, l’addestramento delle intelligenze artificiali (IA) per svolgere questa funzione con precisione ha un costo elevato: servono grandi quantità di immagini mediche già annotate da esperti. Questo requisito limita l’applicazione della IA, soprattutto in contesti con poche risorse o con dati limitati.

È qui che entra in gioco il few-shot learning, o apprendimento con pochi esempi. Questo approccio consente di addestrare una rete neurale con una quantità minima di dati, rappresentando una rivoluzione potenziale per la medicina digitale. Il problema? Quando si confronta con i metodi tradizionali, mostra ancora grandi differenze di prestazioni, specialmente su compiti nuovi o immagini mai viste prima.

Un importante passo avanti in questa direzione arriva da uno studio pubblicato nel 2025 da Yuhui Song e colleghi nella rivista Artificial Intelligence in Medicine. Gli autori propongono un modello di rete neurale innovativo chiamato Interactive Prototype Learning and Self-Learning Network, progettato proprio per affrontare i limiti attuali del few-shot learning nella segmentazione medica.

I due principali ostacoli della segmentazione con pochi dati

L’addestramento di una rete neurale con pochi esempi (le cosiddette immagini “supporto”) per poi applicare quanto appreso a nuove immagini (dette “query”) presenta due difficoltà principali:

- Incoerenza intra-classe: una stessa struttura anatomica può apparire molto diversa da paziente a paziente o a seconda del macchinario utilizzato. Questo disorienta l’IA, che fatica a riconoscere una “classe” con pochi riferimenti.

- Somiglianza inter-classe: strutture diverse, come muscoli, tessuti o piccoli organi, possono sembrare simili, generando ambiguità nell’identificazione automatica.

Queste sfide nascono principalmente dalle grandi differenze di distribuzione tra le immagini di supporto e quelle di query, e compromettono l’accuratezza della segmentazione automatica.

Un nuovo approccio: apprendimento prototipico interattivo e autoapprendimento

Per risolvere queste problematiche, gli autori propongono una rete con tre moduli chiave:

1. Modulo di codifica-decodifica profondo

Utilizzando architetture di deep learning, questo modulo estrae caratteristiche semantiche complesse sia dalle immagini di supporto che da quelle di query. Da queste caratteristiche vengono costruiti i cosiddetti prototipi di picco, ovvero rappresentazioni astratte ad alto contenuto informativo, che fungono da guida per la segmentazione.

2. Apprendimento prototipico interattivo

In questa fase, la rete confronta e interagisce con i prototipi a due livelli:

- Livello medio: l’interazione tra medie delle caratteristiche aiuta a uniformare le immagini della stessa classe.

- Livello alto: i prototipi di picco sono confrontati per ridurre la confusione tra classi diverse.

Questa doppia interazione mira a migliorare la coerenza intra-classe e ridurre la somiglianza inter-classe, due pilastri della segmentazione accurata.

3. Autoapprendimento guidato dalla query

Infine, viene utilizzata la stessa immagine di query per affinare il processo: la rete separa in modo più netto il primo piano (organo o lesione) dallo sfondo. Inoltre, integra informazioni provenienti da mappe di caratteristiche a bassa risoluzione per migliorare la definizione dei bordi, un aspetto cruciale in medicina, dove ogni millimetro può fare la differenza.

Prestazioni e generalizzazione

Il modello è stato testato su diversi dataset benchmark utilizzati comunemente nella ricerca biomedica. I risultati sono molto promettenti:

- Segmentazione precisa anche con pochi esempi.

- Migliore generalizzazione su immagini mai viste.

- Maggiore robustezza rispetto ai modelli precedenti in scenari complessi.

Questo dimostra che la rete non solo impara efficacemente da pochi dati, ma riesce anche ad adattarsi a nuovi contesti, rendendola molto utile per l’applicazione clinica.

Implicazioni per la medicina clinica

Questa tecnologia ha il potenziale di rivoluzionare il modo in cui la segmentazione delle immagini viene integrata nella pratica clinica quotidiana:

- Ospedali con risorse limitate potrebbero implementare sistemi IA efficaci senza grandi database.

- Diagnosi rapide in emergenze, dove il tempo per annotare i dati è limitato.

- Supporto in malattie rare, dove i casi disponibili per l’addestramento sono pochi.

Il futuro: meno dati, più intelligenza

Il lavoro di Song e colleghi mostra che non servono sempre milioni di dati per creare una IA efficace. Serve piuttosto un’architettura intelligente, capace di valorizzare al massimo le poche informazioni disponibili e di adattarsi dinamicamente.

Nel prossimo futuro, reti come questa potrebbero diventare strumenti quotidiani nelle mani di medici, tecnici e ricercatori, offrendo segmentazioni rapide, precise e affidabili, anche in contesti difficili.

🔗 Riferimento:

Song, Y., Xu, C., Wang, B., Du, X., Chen, J., Zhang, Y., & Li, S. (2025). Interactive prototype learning and self-learning for few-shot medical image segmentation. Artificial Intelligence in Medicine, 103183. https://doi.org/10.1016/j.artmed.2025.103183

#ArtificialIntelligence #Medicine #Surgery #Medmultilingua

Lascia un commento